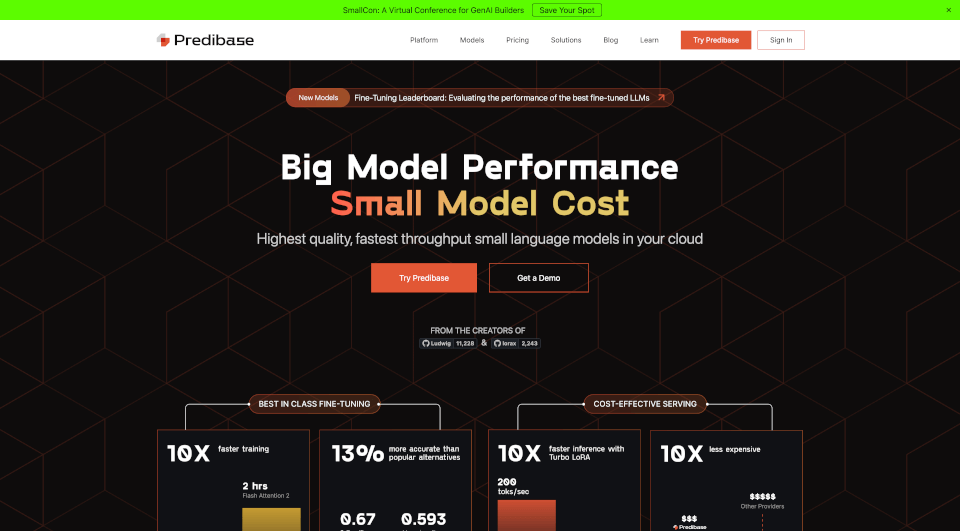

Predibase官网网页版登录入口

- Predibase官网地址:https://predibase.com/

Predibase 是一个专为开发者设计的平台,专注于微调和部署大型语言模型(LLMs)。它允许你在自己的云环境或 Predibase 的云中定制和部署开源模型,性能甚至可以超越 GPT-4。无论是代码生成、内容总结,还是客户服务自动化,Predibase 都能提供高效的解决方案。

Predibase的核心功能

模型微调:支持量化、低秩适应和内存高效分布式训练,快速定制小型模型。

模型部署:通过 Turbo LoRA 和 LoRAX 技术,在单个 GPU 上高效部署多个微调模型,速度比竞品快 2-3 倍。

私有云支持:在虚拟私有云中安全地定制模型,确保数据隐私和 IP 控制。

开源模型支持:支持 Llama-3、Phi-3、Mistral 等主流开源模型,轻松部署和测试。

Predibase的使用案例

代码生成:自动生成代码,减少开发负担。

内容总结:快速提取文档或文章的核心内容。

客户服务自动化:自动分类支持问题并生成客户响应。

信息提取:从非结构化文本中提取结构化信息。

如何使用Predibase

1. 部署 HuggingFace 上的 LLM 模型:

“`python

pb.deployments.create(

name=\\\”my-llama-3-70b-deployment\\\”,

description=\\\”Deployment of Llama 3 70b in Predibase Cloud\\\”,

config=DeploymentConfig(

base_model=\\\”llama-3-70b\\\”,

)

)

“`

2. 微调模型:

“`python

adapter = pb.adapters.create(

config=FinetuningConfig(

base_model: \\\”llama-3-70b\\\”,

epochs: 3,

learning_rate: 0.0002,

),

dataset=my_dataset,

repo=\\\”my_adapter\\\”,

description=\’Fine-tune llama-3-70b with my dataset for my task.\’,

)

“`

Predibase常见问题:

Q:: Predibase 支持哪些开源模型?

A: Predibase 支持 Llama-3、Phi-3、Mistral 等多种主流开源模型。

Q:: 如何在 Predibase 上部署模型?

A: 可以通过几行代码或用户友好的 UI 轻松部署模型,支持 HuggingFace 上的模型。

Q:: Predibase 的微调技术有哪些优势?

A: Predibase 采用量化、低秩适应和内存高效分布式训练等技术,确保微调过程快速且高效。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

想要以后继续访问本站,按住Ctrl+D键,把aoxox.com收藏起来吧!